Microsoft được cho đang đặt mục tiêu tích lũy 1,8 triệu chip AI, trong khi Tesla, Meta, Google cũng gom hàng trăm nghìn GPU cho hệ thống của mình.

Theo tài liệu nội bộ do Business Insider thu thập, Microsoft có kế hoạch tăng gấp ba số GPU hiện có. Đến hết năm, công ty đặt mục tiêu sở hữu 1,8 triệu chip AI, hầu hết do Nvidia sản xuất, nhưng cũng có thể mua thêm từ các đối tác khác. Hai nguồn tin khác cho biết tính đến năm tài chính 2027, công ty dự kiến chi 100 tỷ USD để mua GPU và xây dựng trung tâm dữ liệu. Microsoft từ chối bình luận.

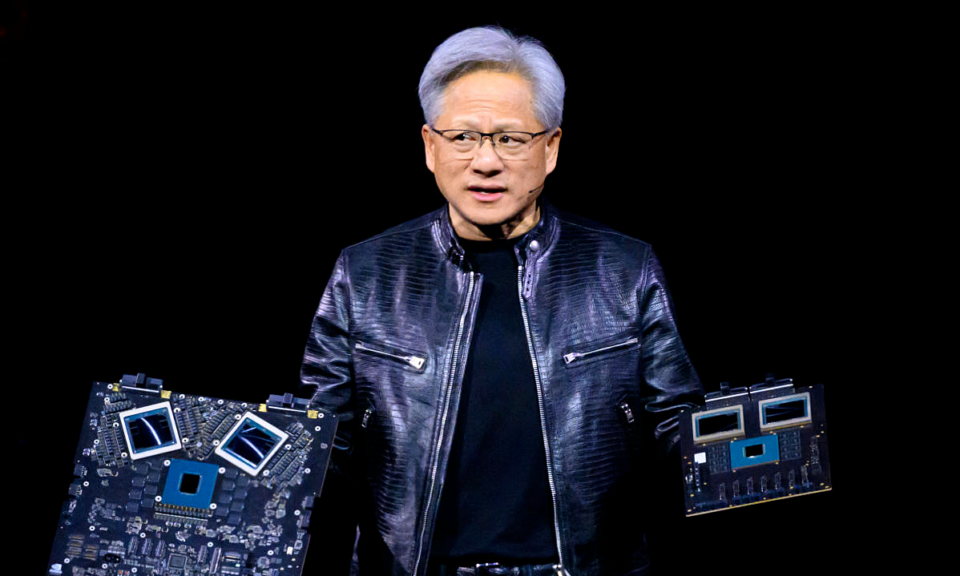

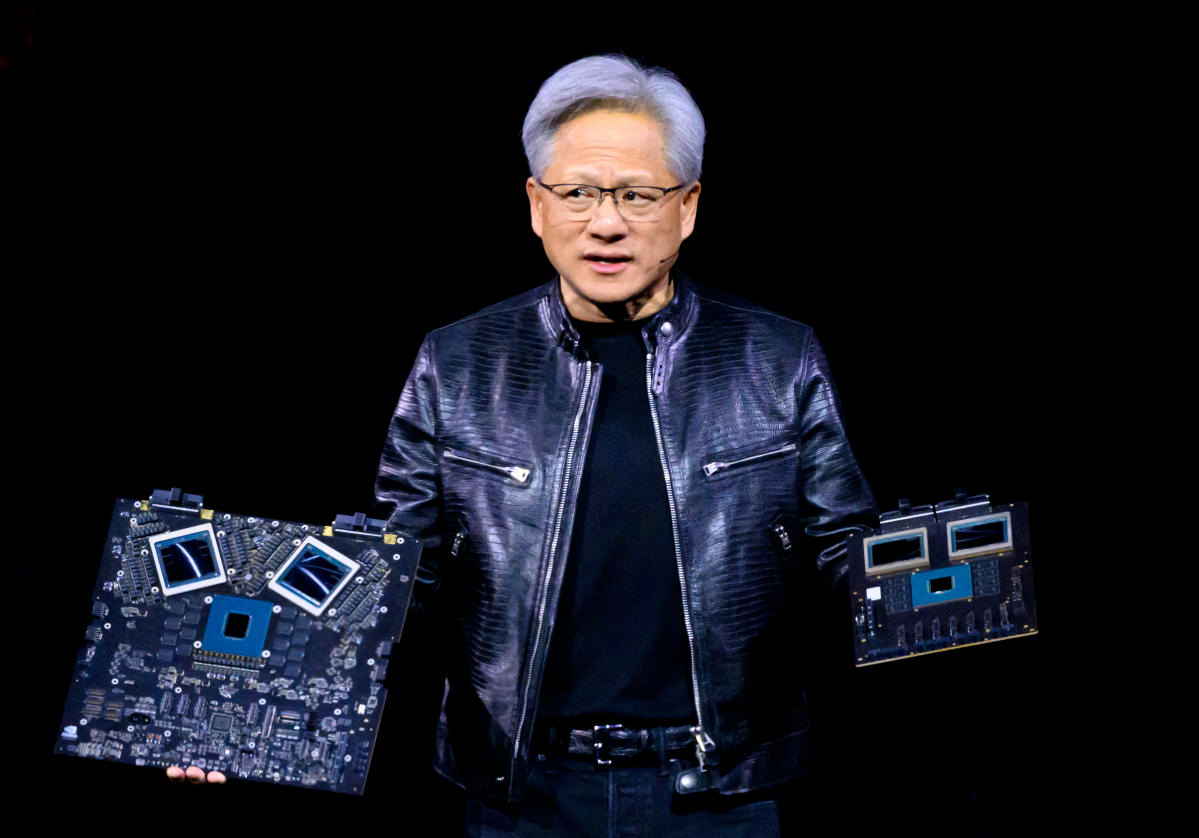

CEO Nvidia Jensen Huang với các mẫu chip AI Blackwell tại sự kiện ngày 19/3. Ảnh: Nvidia

Các nhà phân tích tại DA Davidson ước tính Microsoft đã chi 4,5 tỷ USD để mua chip Nvidia năm ngoái. Dù không xác nhận, một giám đốc của Microsoft nói với Bloomberg rằng con số này “nằm trong mức chi tiêu thực tế” của công ty.

Microsoft cũng đang nỗ lực phát triển chip AI tùy chỉnh nhằm giảm sự phụ thuộc vào Nvidia. Tuy nhiên, chính các nhân viên cũng tỏ ra hoài nghi vì công ty đi sau Nvidia nhiều năm, trong khi công nghệ trí tuệ nhân tạo phát triển quá nhanh.

Bộ xử lý đồ họa GPU hiện là sản phẩm được săn lùng nhờ khả năng tính toán và xử lý dữ liệu tốc độ cao – yếu tố cần thiết đối với các mô hình ngôn ngữ lớn (LLM). Hiện GPU của Nvidia được đặt mua nhiều nhất, trong khi các hãng khác như AMD cũng bắt đầu cuộc đua với sản phẩm tương tự. Trên thị trường, mỗi GPU H100 của Nvidia có giá 30.000-40.000 USD. Tháng trước, công ty giới thiệu mẫu Blackwell nhanh hơn nhiều lần thế hệ cũ với giá bán tương đương.

Ngoài Microsoft, các ông lớn công nghệ khác cũng đang tích cực tạo dựng kho GPU khổng lồ của mình. Hồi tháng 1, CEO Meta Mark Zuckerberg cho biết sẽ mua 350.000 mẫu H100 trong năm 2024 để phục vụ đào tạo mô hình AI, nâng tổng số GPU sở hữu lên 600.000 chip.

Theo Zuckerberg, Meta đang xây dựng trí tuệ tổng quát (General Intelligence) với mục tiêu hỗ trợ AI “có sẵn và hữu ích cho mọi người trong cuộc sống hàng ngày”. “Chúng tôi đã sẵn sàng xây dựng một hệ thống đào tạo AI với quy mô có thể lớn hơn bất kỳ công ty riêng lẻ nào khác”, ông nói với The Verge ngày 19/1.

Trong khi đó, Elon Musk năm ngoái đặt hàng 10.000 chip cho công ty xAI. Hồi đầu tháng, khi tài khoản The Technology Brother nói nhắc đến việc tích trữ GPU H100 của Meta, Musk đáp rằng Tesla sẽ đứng thứ hai và xAI sẽ đứng thứ ba về lượng chip AI tích lũy “nếu tính toán đúng”.

Đầu năm nay, Elon Musk cho biết Tesla đã đầu tư thêm 500 triệu USD cho siêu máy tính Dojo của Tesla, đồng thời “sẽ chi tiền nhiều hơn” cho phần cứng Nvidia để duy trì tính cạnh tranh. “Sẽ cần ít nhất hàng tỷ USD mỗi năm”, tỷ phú Mỹ viết trên X.

Theo dữ liệu của công ty nghiên cứu thị trường Omdia cuối năm ngoái, Meta và Microsoft là hai khách hàng lớn nhất của H100, khi mỗi công ty mua 150.000 chip, gấp ba so với mức 50.000 chip của các hãng công nghệ khác như Google, Amazon hay Oracle.

OpenAI, công ty đứng sau ChatGPT, không tiết lộ con số cụ thể. Tuy nhiên, vào tháng 8/2023, CEO Sam Altman khẳng định công ty vẫn thiếu chip đồ họa dù đã có “hàng chục nghìn” mẫu A100 và H100 cho GPT-4. Hồi tháng 2, các chuyên gia phân tích của Morgan Stanley cũng cho rằng khi GPT-5 ra mắt, nó có thể cần 25.000 mẫu H100.

Các doanh nghiệp Trung Quốc cũng tích cực mua GPU, dù bị hạn chế do lệnh cấm từ Mỹ. Năm ngoái, Nvidia chỉnh sửa H100 thành phiên bản H800, còn A100 thành A800 với hiệu năng thấp hơn để không vi phạm lệnh cấm. Nhưng từ giữa tháng 10/2023, H800 và A800 cũng có tên trong danh sách hạn chế. Theo Chủ tịch Tencent Martin Lau, công ty ông đã tích trữ đủ chip, chủ yếu là H800, để phát triển AI mang tên Hunyuan “trong ít nhất một vài thế hệ”.

Nhiều tập đoàn lớn của Trung Quốc như Alibaba, ByteDance, Baidu khi đó cũng đặt đơn hàng chip AI trị giá tới 5 tỷ USD từ Nvidia. Tuy nhiên, đơn hàng sau đó được cho là bị hủy do Mỹ đẩy nhanh tiến độ triển khai lệnh cấm.

Bảo Lâm

- Chi phí vận hành OpenAI Sora có thể lên hàng tỷ USD

- Chip AI mạnh nhất của Nvidia có giá hơn 30.000 USD

- Nvidia ra chip AI nhanh hơn chục lần thế hệ cũ

- Cuộc đua chip AI giữa chú cháu Jensen Huang và Lisa Su

- Jensen Huang nói Nvidia ‘không thể bị đánh bại’

Nguồn VnExpress Source link freeslots dinogame